現地時間で2022/5/11に行われたGoogle I/Oで発表された、AR関連のニュースは大きく2点あります。

・グラス型デバイスのデモ映像公開

・ARCoreのアップデート

この2点について、本記事で掘り下げていきます。

グラス型デバイスのデモ映像公開

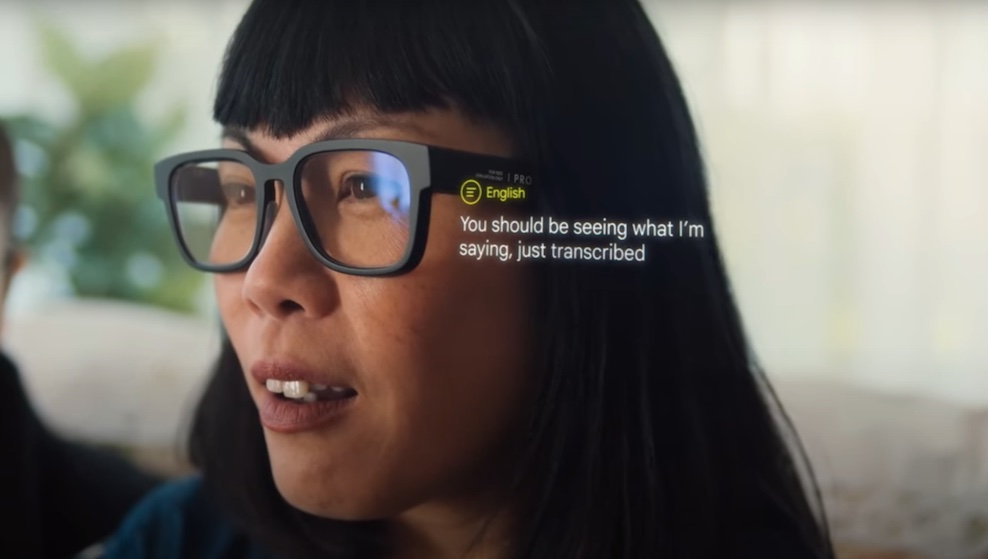

Google I/Oでは、基調講演の最後のサプライズとしてデバイスの発表をしました。映像では英語の文字起こしや、英語と中国語のリアルタイム翻訳が紹介されています。

実際にグラスをかけている映像を見ると、かなりの薄型で、メガネに近い形をしています。

ただし、デモ映像では自動翻訳をしているシーンしか登場していないことに注意が必要です。Hololens2やNreal Lightのような外部を認識するARの機能はついていない可能性があります。

また、形状としてはNreal Airに近いですが、コードが見当たらないところから、スマートフォンとBluetoothなどで接続し、ディスプレイとして使用する形になるのではないかと予想できます。サングラスのような光をシャットアウトするような見た目ではないため、どのような見え方になるのかも注目です。

Nrieal Airの使用感についてはこちらにも掲載しています。

また、直近で話題になっているARデバイスのまとめはこちらになります。

ARCoreのアップデート

ARCoreもアップデートが発表されています。

既存の機能も認識スピードや表示位置の改善がされており、新規に追加された機能もあります。細かくみていきましょう。

既存機能の改善

Motion Tracking

Motion Trackingはある地点に表示したオブジェクトを同じ位置に表示させ続ける、基本的な機能です。動画の4:05以降では空中に表示された矢印のオブジェクトが、移動やカメラの遮断があってもその場に止まり続ける様子がみられます。

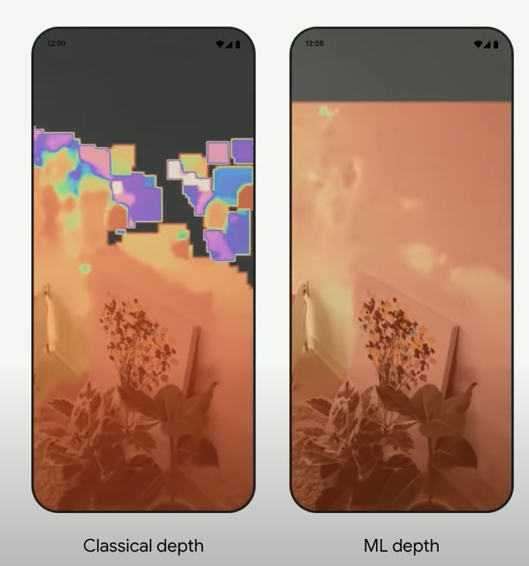

Depth

前後の判定をするOcclusionや、現実の物体に触ったかどうかを判定するInteractionが該当します。ここでもOcclusionのために生成するメッシュの生成スピードが速くなり、カバーできる領域が増えています。

さらに、デュアルカメラを備えるPixel4やPixel6はさらに速くメッシュが生成できるようです。

新機能

Long Range Depth

これまでのDepthでは遠すぎる場所の深度判定は難しい部分がありました。Long Range Depthでは20mまでの深度判定ができるようになったようです。これにより、遠くに設置したオブジェクトのオクルージョン判定が可能になります。Google Mapではすでに使われ始めているようです。

Geospatial api

緯度経度や周辺環境の特徴量をもとに現実世界の指定した位置にARを表示する、いわゆるロケーションベースのARを表示する機能です。

Google Mapの機能として「Live View」という実際の景色に合わせて案内をしてくれる機能がありますが、そこで使用されているものをApiとして解放した形になります。

https://developers.google.com/ar/develop/geospatial

類似サービスとしてはSnapないで利用できる「City Landmarker Template」やSTYLYの「リアルメタバースプラットフォーム」、プレティア・テクノロジーズの「Pretia」などがあります。

SnapはCity Landmarker Templateはロンドンのみで提供されています。ただし、別途自分であらかじめ出したい位置の周辺情報をスキャンすることで、その場所で表示させる機能があります。

STYLYのリアルメタバースプラットフォームは東京・大阪・名古屋・札幌・福岡・京都の6都市で使用可能です。

Pretiaは、あらかじめ情報をスキャンしておくことで、狙った場所に出現させる方法をとっています。

まとめ

グラス型デバイスはデモに過ぎないため過度な期待は禁物ですが、最後にご紹介したGeospatial apiはAR業界にかなり大きなインパクトをもたらすことでしょう。

また、直近は発表会ラッシュを迎えています。5月末にはNiantic、6月頭にはAppleもカンファレンスを控えており、どのような発表をするか注目です。